Comment savoir si votre nouveau contenu est visible dans les résultats de recherche ? L’indexation par Google peut varier de quelques jours à plusieurs semaines. Mais il existe des actions simples à mettre en place pour accélérer ce processus.

Table des matières

Demander l’indexation à la Search Console Vérifier votre fichier Robots.txt Détecter les balises Noindex Intégrer un plan de site Inspecter vos balises canoniques Travailler votre maillage interne Récupérer des backlinksDemander l’indexation à la Search Console

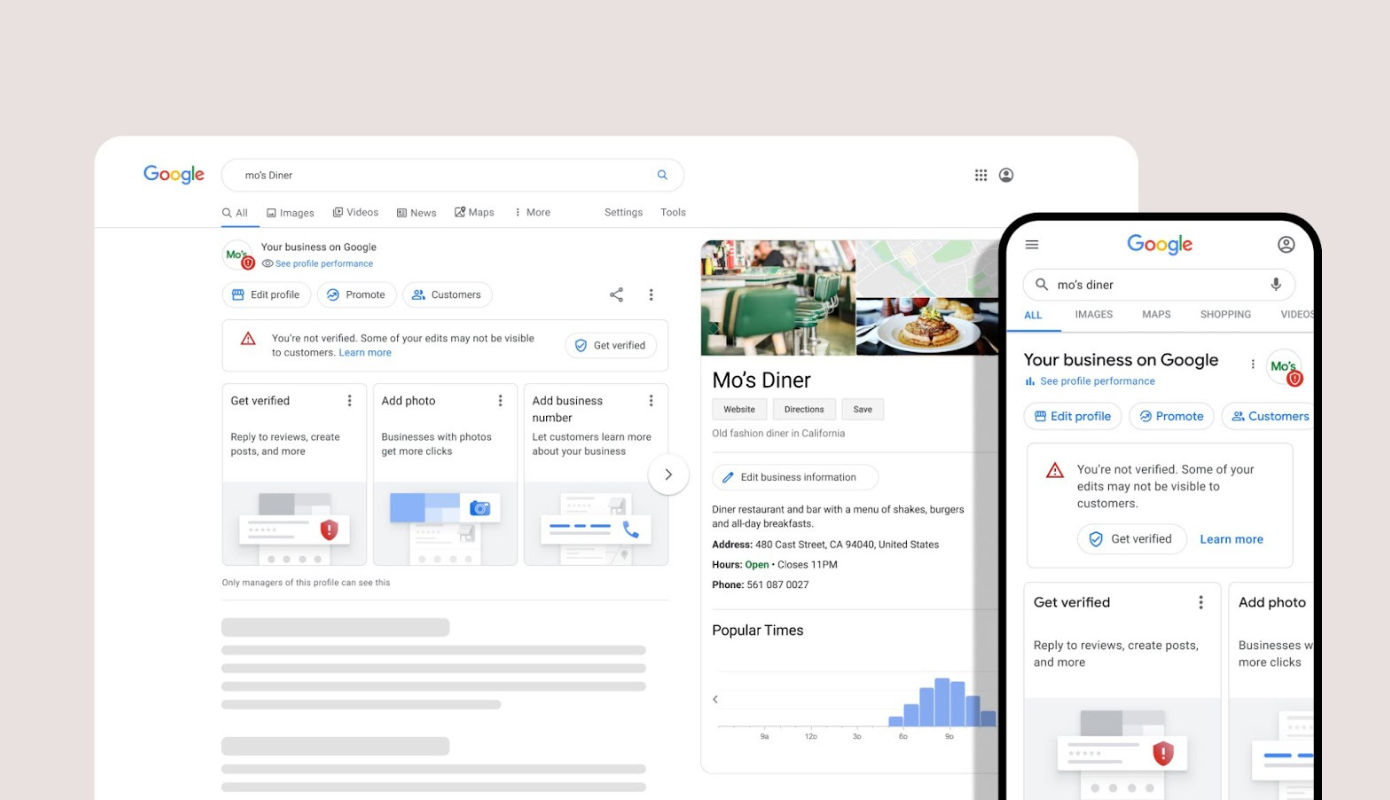

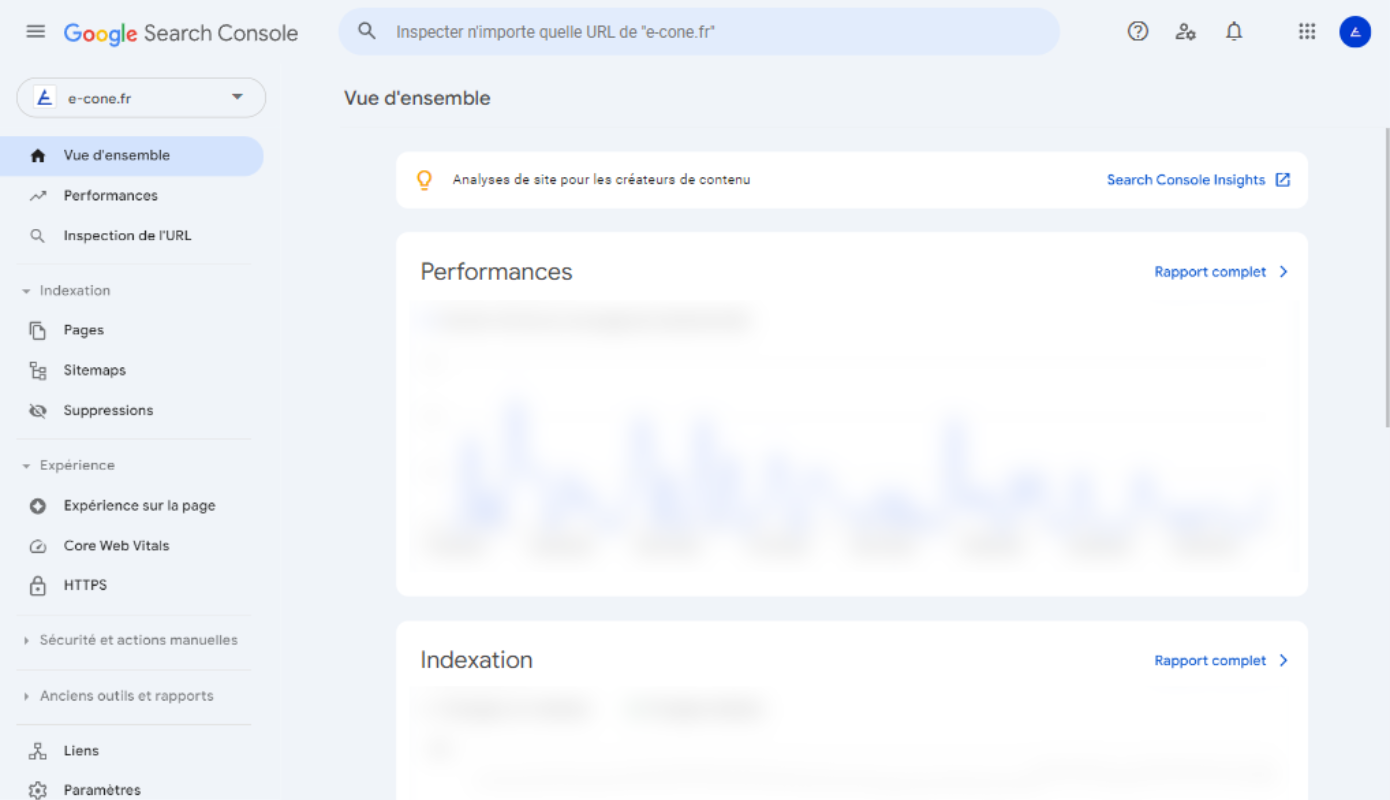

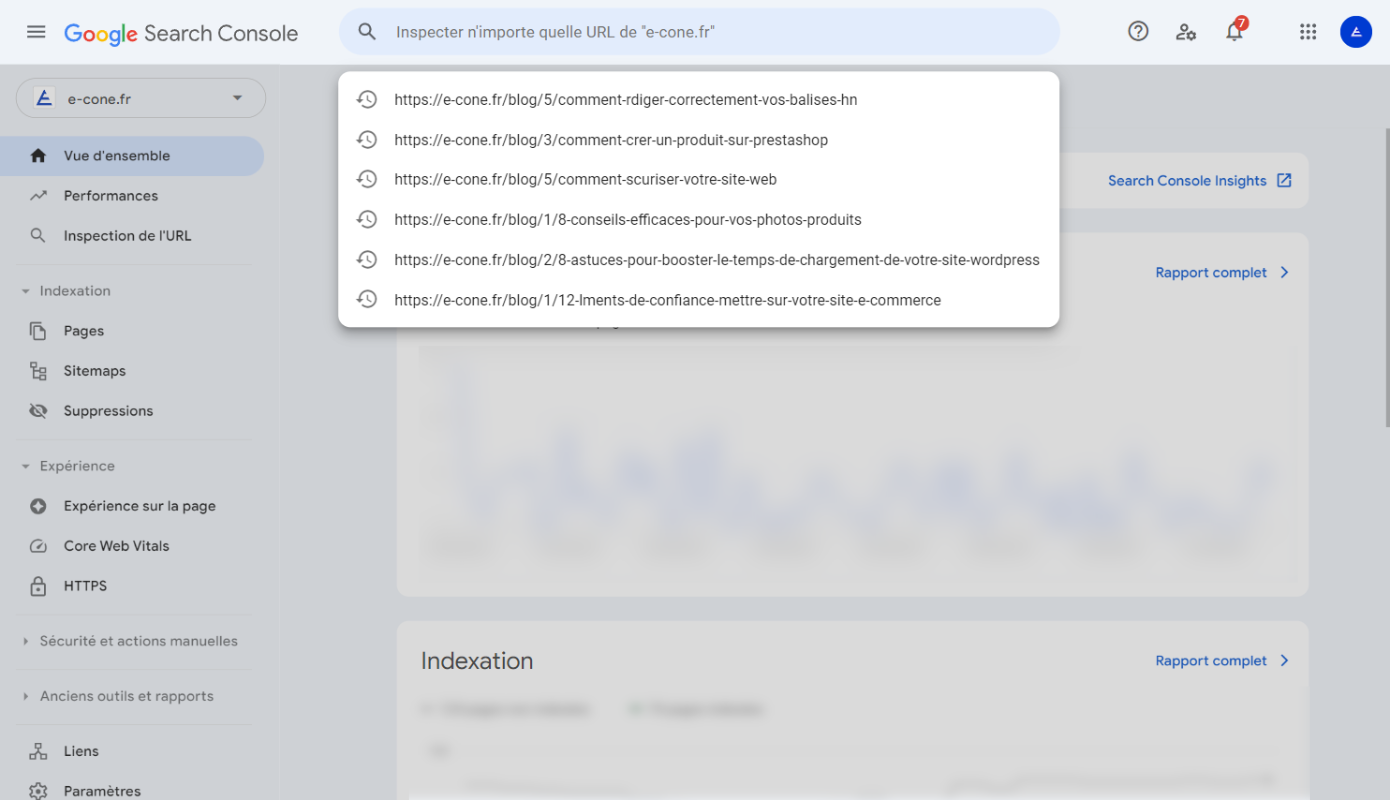

La méthode la plus directe pour faire indexer votre site consiste à utiliser la Google Search Console. Connectez-vous à votre compte Google Search Console et sélectionnez la propriété de votre site. Ensuite, accédez à l'outil d'inspection des URL, situé dans le menu de gauche. Dans cet outil, vous verrez une barre de recherche où vous pouvez entrer l'URL spécifique que vous souhaitez faire indexer.

Collez l'URL dans cette barre et appuyez sur la touche Entrée. Google commencera à vérifier l'URL. Si l’URL n'est pas encore indexée, vous verrez un message. À ce stade, cliquez sur le bouton « Demander l’indexation ». Cela enverra une requête à Google pour qu'il inclue cette page dans son index.

Cependant, si votre site est nouveau, l’indexation ne se fera pas du jour au lendemain. Il faut parfois plusieurs jours, voire semaines, pour que Googlebot explore et indexe entièrement votre site.

De plus, assurez-vous que votre site est correctement configuré pour permettre à Googlebot de l’explorer. Vérifiez que vous n'avez pas de directives robots.txt bloquant l'accès à certaines pages et assurez-vous que votre sitemap XML est soumis et mis à jour régulièrement.

Vérifier votre fichier Robots.txt

Le fichier Robots.txt joue lui aussi un rôle dans l'exploration de votre site. Ce fichier est reconnu par Googlebot, le robot d'exploration de Google, comme une série d'instructions sur les parties du site qu'il doit explorer ou ignorer (c’est un peu son GPS). Il est également analysé par d'autres robots de moteurs de recherche tels que Bing, Yahoo, et d'autres encore.

En configurant correctement votre fichier Robots.txt, vous pouvez optimiser l'efficacité de l'exploration en indiquant aux robots quelles pages sont les plus importantes. Cela permet de s'assurer que les ressources de votre site ne sont pas surchargées par des requêtes inutiles. Par exemple, vous pouvez empêcher les robots d'explorer des sections de votre site qui contiennent des contenus dupliqués, des pages d'administration, ou des ressources non pertinentes pour l'indexation (qui n’ont pas besoin d’apparaître dans les résultats de recherche).

Il est également recommandé de vérifier que les pages que vous souhaitez voir indexées ne soient pas accidentellement marquées comme non-indexables dans votre fichier. Une simple erreur dans ce fichier peut empêcher des pages importantes d'apparaître, ce qui pourrait nuire à la visibilité de votre site.

Détecter les balises Noindex

Si certaines de vos pages ne sont pas indexées, cela pourrait être dû à la présence de balises « noindex ». Ces balises signalent aux moteurs de recherche de ne pas indexer ces pages. Pour résoudre ce problème, il faut vérifier la présence de ces balises et les retirer si nécessaire. Voici comment procéder :

Les balises Meta

Les balises Meta noindex peuvent empêcher l'indexation de vos pages. Pour identifier quelles pages de votre site contiennent ces balises, commencez par rechercher des alertes telles que « page noindex ». Plusieurs outils en ligne peuvent vous aider à détecter ces balises. Une fois que vous avez identifié une page marquée avec la balise noindex, suivez ces étapes :

- Supprimez la balise noindex : Accédez au code source de la page et retirez la balise Meta noindex.

- Soumettez l’URL à Google : Utilisez la Google Search Console pour soumettre à nouveau l’URL et demander son indexation.

Les balises X-Robots

Les balises X-Robots peuvent également empêcher l'indexation de certaines pages. Ces balises se trouvent dans les en-têtes HTTP de vos pages et peuvent être plus difficiles à repérer sans outils appropriés. Voici comment les détecter et les gérer :

- Utilisez la Google Search Console : Rendez-vous dans la Search Console de Google et utilisez l’outil d’inspection des URL. Entrez l’URL de la page que vous souhaitez vérifier.

- Vérifiez l'indexation autorisée : Après avoir entré l’URL, cherchez la réponse à la question « Indexation autorisée ? ». Si vous voyez les mots « Non : ‘noindex’ détecté dans la balise X-Robots-Tag », cela signifie que la page est bloquée par une balise X-Robots.

- Modifiez les en-têtes HTTP : Accédez à la configuration du serveur web où la page est hébergée. Localisez la directive X-Robots-Tag et supprimez l'option noindex. Cela peut nécessiter une intervention dans les fichiers de configuration du serveur (comme .htaccess pour Apache) ou dans les paramètres d’en-têtes HTTP si vous utilisez un autre serveur web.

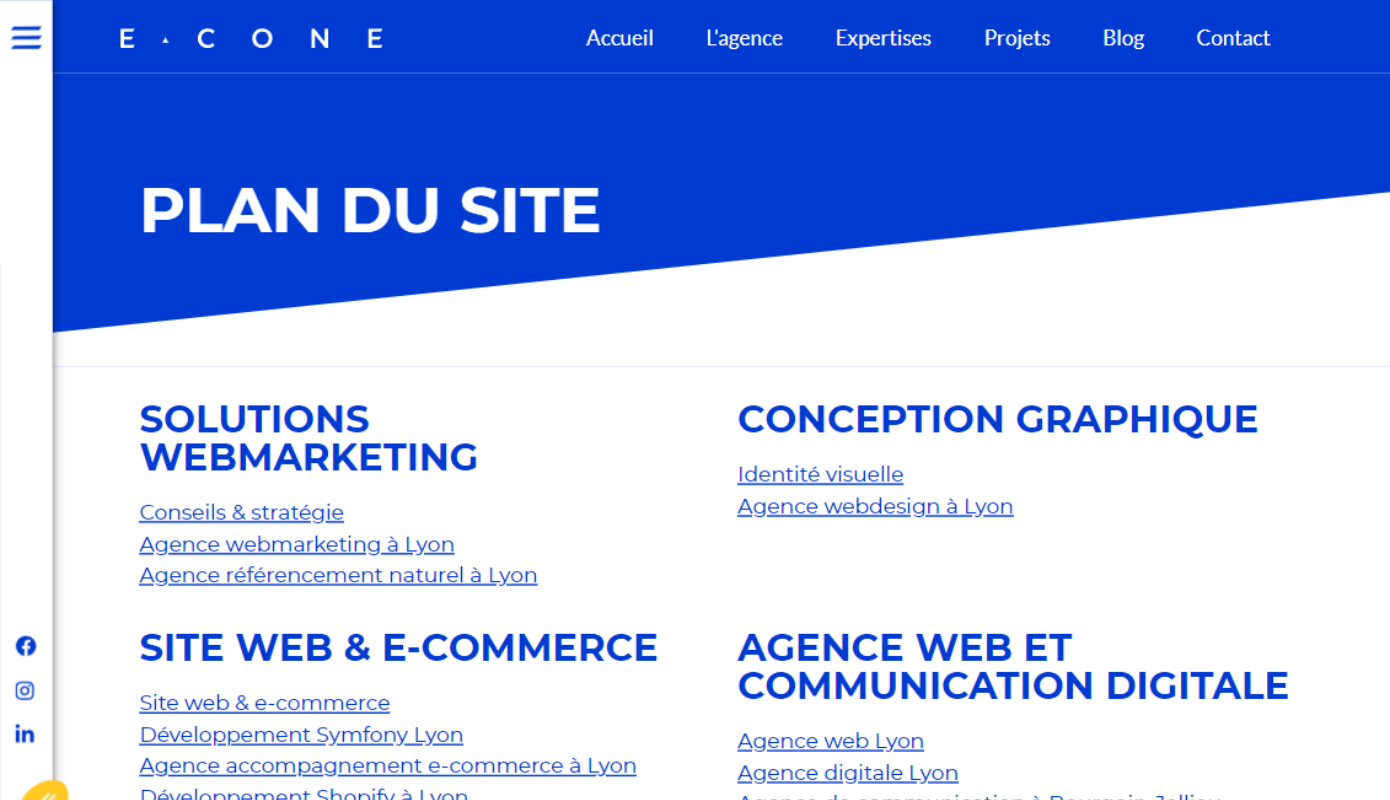

Intégrer un plan de site

Une méthode couramment utilisée pour accélérer l'indexation de votre contenu consiste à créer et soumettre un fichier sitemap. Ce fichier informe Google de la structure de votre site, incluant les pages, images et vidéos qu'il contient.

Qu'est-ce qu'un sitemap ?

Un sitemap est un fichier XML qui liste toutes les URL de votre site et fournit des informations supplémentaires sur chaque URL, telles que la date de la dernière mise à jour, la fréquence des modifications et l'importance des pages. Cela permet à Google de mieux explorer et comprendre votre site.

L'utilisation d'un sitemap est particulièrement avantageuse dans plusieurs situations spécifiques :

- Sites avec de nombreuses pages : Lorsque votre site contient un grand nombre de pages, il est possible que certaines d'entre elles soient négligées par les robots d'exploration de Google. Un sitemap garantit que toutes vos pages sont découvertes et indexées.

- Pages non reliées entre elles : Si toutes vos pages ne sont pas interconnectées par des liens internes, il peut être difficile pour Google de naviguer à travers votre site. Un sitemap aide à établir les relations entre différentes URL et à découvrir des pages orphelines qui pourraient autrement rester invisibles.

- Sites récents sans backlinks : Les nouveaux sites web peuvent avoir du mal à obtenir des backlinks, ce qui est un facteur important pour l'indexation. Un sitemap permet de signaler la présence de vos pages à Google, facilitant ainsi leur découverte et leur indexation initiale.

Inspecter vos balises canoniques

Les balises canoniques permettent d’informer les robots d’exploration des moteurs de recherche sur la version préférée d’une page web. Lorsqu'une page ne comporte pas de balise canonique, Googlebot la traite comme la version principale et unique de cette page. Ainsi, il va l'indexer et la considérer comme la référence à afficher dans les résultats de recherche.

En revanche, si une page contient une balise canonique, cela indique à Googlebot qu'il existe une version alternative considérée comme la version principale. Dans ce cas, Googlebot ne va pas indexer la version actuelle, mais cherchera à indexer la version désignée par la balise canonique

Prenons un exemple :

- https://www.monsite.com/chaussures/nike-air-max-rouge

- https://www.monsite.com/chaussures/nike-air-max-bleu

- https://www.monsite.com/chaussures/nike-air-max-vert

Ces pages présentent des variantes de couleur d'un même modèle de chaussures. Pour éviter que Google ne considère ces pages comme du contenu dupliqué, vous pouvez utiliser les balises canoniques pour indiquer à Googlebot quelle page doit être indexée comme version principale.

Une utilisation correcte des balises canoniques peut prévenir les problèmes de contenu dupliqué, améliorer la gestion de vos URL et optimiser l'indexation de votre site.

Travailler votre maillage interne

Le maillage interne aide les robots d'exploration à découvrir vos pages web. En parcourant votre site, ces robots suivent les liens internes pour accéder à différentes sections et contenus, facilitant ainsi leur indexation.

Pour améliorer l'indexation de votre site, il est recommandé de supprimer les liens internes dotés de l'attribut nofollow. Cet attribut indique aux robots d'exploration de ne pas suivre le lien, et lorsque Googlebot rencontre une balise nofollow, il signale à Google de ne pas indexer la page cible marquée. En éliminant les liens nofollow inutiles, vous permettez aux robots de mieux explorer et indexer votre site.

Une stratégie efficace pour optimiser l'indexation consiste à ajouter des liens internes sur vos pages les plus performantes. Ces pages, qui bénéficient déjà d'une bonne visibilité et d'un bon classement, peuvent servir de passerelles vers vos nouveaux contenus.

Récupérer des backlinks

Google reconnaît la valeur et l'importance d'une page lorsqu'elle reçoit des recommandations de sites web ayant une forte autorité dans leur domaine. Ces recommandations prennent la forme de backlinks, qui sont des liens entrants provenant de ces sites réputés. Lorsque des sites influents incluent des liens vers une page spécifique, cela envoie un signal positif à Google.

Ce signal indique que la page contient probablement un contenu de qualité et pertinent, ce qui incite Google à l'indexer plus rapidement. En somme, obtenir des backlinks de sites faisant autorité est important pour améliorer la visibilité et la crédibilité de votre site aux yeux de Google, facilitant ainsi son indexation et, par conséquent, son positionnement dans les résultats de recherche.